|

||

|

|

||

|

|

Онлайн книга - Искусственный интеллект. Этапы. Угрозы. Стратегии | Автор книги - Ник Бостром

Cтраница 133

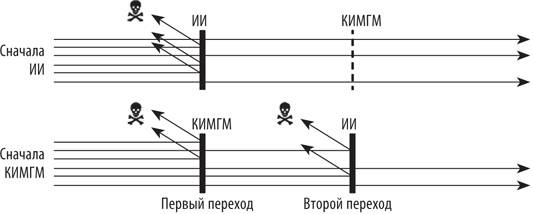

Прежде всего, это наличие технологических связок, которые мы уже обсуждали. Было отмечено, что усилия по созданию имитационной модели мозга могут привести к появлению нейроморфного ИИ, то есть особенно опасной формы машинного интеллекта. Но на время допустим, что мы действительно добились своей цели и создали компьютерную имитационную модель головного мозга (далее по тексту — КИМГМ). Будет ли она безопаснее ИИ? Это сложный вопрос. У КИМГМ есть минимум три предполагаемых преимущества перед ИИ: 1) ее характеристики производительности легче понять; 2) ей внутренне присущи человеческие мотивы; 3) в случае ее первенства взлет будет медленным. Предлагаю коротко рассмотреть каждый фактор. 1. То, что характеристики производительности КИМГМ понять легче, чем ИИ, звучит убедительно. У нас в изобилии информации о сильных и слабых сторонах человеческого интеллекта, но нет никаких знаний об ИИЧУ. Однако понимать, что может или не может делать оцифрованный моментальный снимок человеческого интеллекта, не то же самое, что понимать, как этот интеллект будет реагировать на изменения, направленные на повышение его производительности. В отличие от него, ИИ можно изначально тщательно проектировать таким образом, чтобы он был понятен как в статическом, так и в динамическом состоянии. Поэтому хотя интеллектуальная производительность КИМГМ может оказаться более предсказуемой на сравнимых стадиях их разработки, неясно, будет ли она динамически более предсказуемой, чем ИИ, созданный компетентными и озабоченными проблемой безопасности программистами. 2. Нет никакой гарантии, что КИМГМ будет непременно присуща мотивация ее человеческого прототипа. Чтобы скопировать оценочные характеристики человеческой личности, может потребоваться слишком высокоточная модель. Даже если мотивационную систему отдельного человека удастся скопировать точно, неясно, насколько безопасным это окажется. Люди могут быть лживыми, эгоистичными и жестокими. И хотя можно надеяться, что прототип будет выбран за его исключительную добродетель, трудно спрогнозировать, как он станет действовать после переноса в совершенно чуждую ему среду, после повышения его интеллектуальных способностей до сверхчеловеческого уровня и с учетом возможности захватить господство над миром. Верно лишь то, что у КИМГМ будет более человекоподобная мотивация (они не станут ценить лишь скрепки или знаки после запятой в числе пи). В зависимости от ваших взглядов на человеческую природу это может как обнадеживать, так и разочаровывать [555]. 3. Неясно, почему технология полной эмуляции головного мозга может привести к более медленному взлету, чем технология разработки искусственного интеллекта. Возможно, в случае эмуляции мозга можно ожидать меньшего аппаратного навеса, поскольку она менее эффективна с вычислительной точки зрения, чем ИИ. Возможно, также, что ИИ способен легче превратить всю доступную ему вычислительную мощность в один гигантский интегрированный интеллект, в то время как КИМГМ будут предшествовать появлению сверхразума и опережать человечество лишь с точки зрения быстродействия и возможного количества копий. Если появление КИМГМ приведет к более медленному взлету, то дополнительным преимуществом будет ослабление проблемы контроля. Кроме того, более медленный взлет повысит вероятность многополярного исхода. Но настолько ли он желателен, этот многополярный мир, — большой вопрос. Есть еще одно соображение, которое ставит под сомнение идею безопасности создания вначале технологии эмуляции головного мозга, — необходимость решать проблему второго перехода. Даже если первый машинный интеллект человеческого уровня будет создан в форме эмулятора, возможность появления искусственного интеллекта останется. ИИ в его зрелой форме обладает важными преимуществами по сравнению с КИМГМ, которые делают его несравнимо более мощной технологией [556]. Поскольку зрелый ИИ приведет к моральному устареванию КИМГМ (за исключением специальной задачи по консервации мозга отдельных людей), обратное движение вряд ли возможно. Это означает следующее: если ИИ будет разработан первым, возможно, что у взрывного развития искусственного интеллекта будет всего одна волна; а если первым будет создана КИМГМ, таких волн может быть две. Первая — появление самой КИМГМ, вторая — появление ИИ. Совокупный экзистенциальный риск на пути КИМГМ–ИИ представляет собой сумму рисков, связанных с первым и вторым переходом (обусловленную успешным завершением первого), см. рис. 13 [557].

Рис. 13. Что раньше, искусственный интеллект или компьютерная имитационная модель головного мозга? В сценарии «сначала КИМГМ» есть два перехода, связанных с риском, — вначале в результате создания КИМГМ, затем — ИИ. Совокупный экзистенциальный риск этого сценария представляет собой сумму рисков каждого перехода. Однако риск самого перехода к ИИ может быть ниже, когда это происходит в мире, где уже успешно работает КИМГМ. Насколько более безопасным окажется переход к ИИ в мире КИМГМ? Одно из соображений заключается в том, что переход к ИИ мог бы быть менее взрывным, если случился бы уже после появления какой-то иной формы машинного интеллекта. Имитационные модели, работающие на цифровых скоростях и в количествах, далеко превосходящих население Земли, могли бы сократить когнитивный разрыв и легче контролировать ИИ. Впрочем, этому соображению не стоит придавать слишком большое значение, поскольку разрыв между ИИ и КИМГМ все-таки будет очень значительным. Однако если КИМГМ не просто быстрее и многочисленнее, но еще и качественно умнее людей (или как минимум не уступают лучшим представителям человечества), тогда у сценария с КИМГМ будут преимущества, аналогичные сценарию с когнитивным улучшением биологического мозга, который мы рассматривали выше.

|

Вернуться к просмотру книги

Вернуться к просмотру книги

Перейти к Оглавлению

Перейти к Оглавлению

Перейти к Примечанию

Перейти к Примечанию

© 2020 LoveRead.ec - электронная библиотека в которой можно

© 2020 LoveRead.ec - электронная библиотека в которой можно